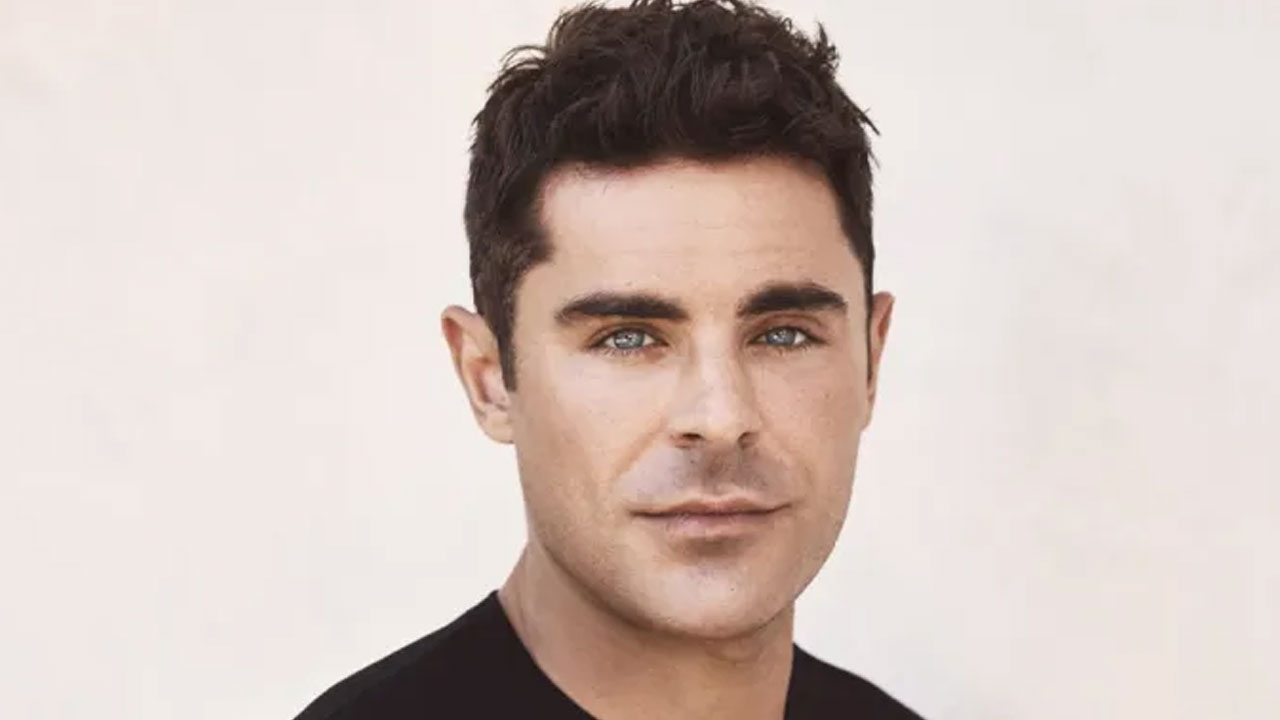

El nuevo método algún día podría ayudar a alertar a los técnicos sobre posibles problemas con equipos como turbinas eólicas o satélites. Derechos de autor: Noticias del MIT

Identificar una sola turbina defectuosa en un parque eólico, lo que puede implicar observar cientos de señales y millones de puntos de datos, es como encontrar una aguja en un pajar.

Los ingenieros suelen simplificar este complejo problema mediante el uso de modelos de aprendizaje profundo que pueden detectar anomalías en las mediciones realizadas repetidamente a lo largo del tiempo por cada turbina, conocidas como datos de series de tiempo.

Pero con cientos de turbinas eólicas que registran docenas de señales cada hora, entrenar un modelo de aprendizaje profundo para analizar datos de series temporales es costoso y engorroso. Esto se ve exacerbado por el hecho de que es posible que sea necesario volver a capacitar el modelo después de su implementación y que los operadores de parques eólicos pueden carecer de la experiencia necesaria en aprendizaje automático.

En un nuevo estudio, investigadores del MIT descubrieron que los modelos de lenguaje grande (LLM) tienen el potencial de ser detectores de anomalías más eficientes para datos de series temporales. Lo importante es que estos modelos previamente entrenados se pueden implementar de inmediato.

Los investigadores desarrollaron un marco llamado SigLLM, que incluye un componente que convierte datos de series temporales en entradas de texto que el LLM puede procesar. El usuario puede introducir estos datos preparados en el formulario y pedirle que comience a identificar la anomalía. LLM también se puede utilizar para pronosticar puntos de datos de series temporales futuras como parte de un proceso de detección de anomalías.

Aunque los modelos de aprendizaje profundo no pudieron superar a los modelos de aprendizaje profundo de última generación en la detección de anomalías, funcionaron tan bien como algunos otros métodos de IA. Si los investigadores pueden mejorar el rendimiento de los modelos de aprendizaje profundo, este marco podría ayudar a los técnicos a identificar problemas potenciales en equipos como maquinaria pesada o satélites antes de que ocurran, sin la necesidad de entrenar un costoso modelo de aprendizaje profundo.

«Dado que este es solo el primer intento, no esperábamos lograrlo en el primer intento, pero estos resultados muestran que aquí existe una oportunidad de capitalizar los LLM para tareas complejas de detección de anomalías».

Sus coautores incluyen a Linh Nguyen, estudiante de posgrado en ingeniería eléctrica y electrónica; Laure Bertie Equil, directora de investigación del Instituto Nacional Francés de Investigación sobre el Desarrollo Sostenible; El autor principal es Kalyan Veeramachaneni, científico investigador principal del Laboratorio de Sistemas de Información y Decisión. ha sido publicado en arksif Servidor de preimpresión, la búsqueda se presentará en Conferencia IEEE sobre ciencia de datos y análisis avanzado.

Solución lista

Los modelos de lenguaje grande son autorregresivos, lo que significa que pueden comprender que los valores más recientes en datos secuenciales dependen de valores anteriores. Por ejemplo, modelos como GPT-4 pueden predecir la siguiente palabra de una oración utilizando las palabras que la preceden.

Dado que los datos de series temporales son secuenciales, los investigadores creyeron que la naturaleza autorregresiva de los modelos LLM podría hacerlos adecuados para detectar anomalías en este tipo de datos.

Pero querían desarrollar una tecnología que evitara el ajuste fino, el proceso en el que los ingenieros vuelven a capacitar a alguien con una pequeña cantidad de datos en una tarea particular para convertirlo en un experto en una sola tarea. En cambio, los investigadores colocan a alguien en el estante, sin pasos de capacitación adicionales.

Pero antes de poder publicarlo, tuvieron que convertir los datos de la serie temporal en texto que el modelo de lenguaje pudiera manejar.

Lo logran a través de una serie de transformaciones que capturan las partes más importantes de la serie temporal y al mismo tiempo representan los datos con la menor cantidad de símbolos. Los símbolos son la entrada básica para LLM y más símbolos requieren más cálculos.

«Si no sigue estos pasos con mucho cuidado, podría terminar cortando una parte importante de sus datos y, por lo tanto, perdiendo esa información», dice Allingheimis.

Una vez que descubrieron cómo transformar los datos de las series temporales, los investigadores desarrollaron dos métodos para la detección de anomalías.

Métodos de detección de anomalías.

Para el primer método, al que llaman Prompter, ingresan datos preparados en el modelo y le solicitan que identifique valores atípicos.

«Tuvimos que iterar varias veces para descubrir qué indicaciones eran correctas para una serie de tiempo específica», añade Allingheimis. «No es fácil entender cómo estos programas ingieren y procesan datos».

Para el segundo enfoque, llamado Detector, utilizan LLM como predictor para predecir el siguiente valor de una serie de tiempo. Los investigadores compararon el valor esperado con el valor real. Una gran discrepancia indica que es probable que el valor real sea anómalo.

Con Detector, LLM será parte del proceso de detección de anomalías, mientras que Prompter completará la tarea por sí solo. En la práctica, Detector funcionó mejor que Prompter, lo que produjo muchos falsos positivos.

«Creo que con el enfoque de Prompter, le pedíamos al LLM que superara muchos obstáculos y le estábamos dando un problema más difícil de resolver», dice Veermachanini.

Cuando compararon ambos enfoques con las técnicas existentes, Detector superó a los modelos de IA basados en transformadores en siete de los 11 conjuntos de datos que evaluaron, a pesar de que el LLM no requirió capacitación ni ajustes.

En el futuro, el LLM también podrá proporcionar explicaciones en lenguaje sencillo con sus predicciones, de modo que el operador pueda comprender mejor por qué el LLM ha identificado un punto de datos particular como anómalo.

Sin embargo, los modelos de aprendizaje profundo de última generación han superado a los modelos de aprendizaje profundo en un grado significativo, lo que demuestra que todavía queda trabajo por hacer antes de que los modelos de aprendizaje profundo puedan usarse para la detección de anomalías.

«¿Qué se necesita para llegar al punto en que funcionen tan bien como estos modelos más nuevos? Esa es la pregunta que enfrentamos ahora. Un detector de anomalías basado en LLM tiene que ser un punto de inflexión para que podamos justificar este tipo de esfuerzo». dice.

En el futuro, los investigadores quieren saber si el ajuste fino puede mejorar el rendimiento, aunque esto requiere tiempo, costos y experiencia en capacitación adicionales.

Sus métodos tardan entre 30 minutos y dos horas en producir resultados, por lo que aumentar la velocidad es un área clave para el trabajo futuro. Los investigadores también quieren probar métodos de obtención de resultados para comprender cómo detectan anomalías, con la esperanza de encontrar una manera de mejorar su rendimiento.

«Cuando se trata de tareas complejas como la detección de anomalías en series temporales, los programas LLM son un verdadero competidor», dice Allingheimis. «¿Quizás también se puedan abordar otras tareas complejas con los programas LLM?»

Para más información:

Sarah Al-Nughimish et al., ¿Pueden los modelos de lenguaje grandes servir como detectores de anomalías sin errores para series temporales? arksif (2024). doi: 10.48550/arxiv.2405.14755

Esta historia se republica con permiso de MIT News (Sitio web: www.mit.edu/newsoffice/), un sitio popular que cubre noticias sobre investigación, innovación y enseñanza en el MIT.

Martirio:Los investigadores utilizan indicadores de lenguaje grandes para señalar problemas en sistemas complejos (2024, 13 de agosto) Obtenido el 13 de agosto de 2024 de https://techxplore.com/news/2024-08-large-language-flag-problems-complex.html

Este documento está sujeto a derechos de autor. Independientemente de cualquier trato justo con fines de estudio o investigación privados, ninguna parte del mismo puede reproducirse sin permiso por escrito. El contenido se proporciona únicamente con fines informativos.

«Alborotador. Amante de la cerveza. Total aficionado al alcohol. Sutilmente encantador adicto a los zombis. Ninja de twitter de toda la vida».

More Stories

Estudio: la actividad de las proteínas cancerosas aumenta el desarrollo del cáncer de próstata

Un nuevo material luminoso puede ser la solución al deterioro de las infraestructuras

Las vesículas extracelulares son prometedoras en el tratamiento de lesiones pulmonares y cerebrales durante el nacimiento