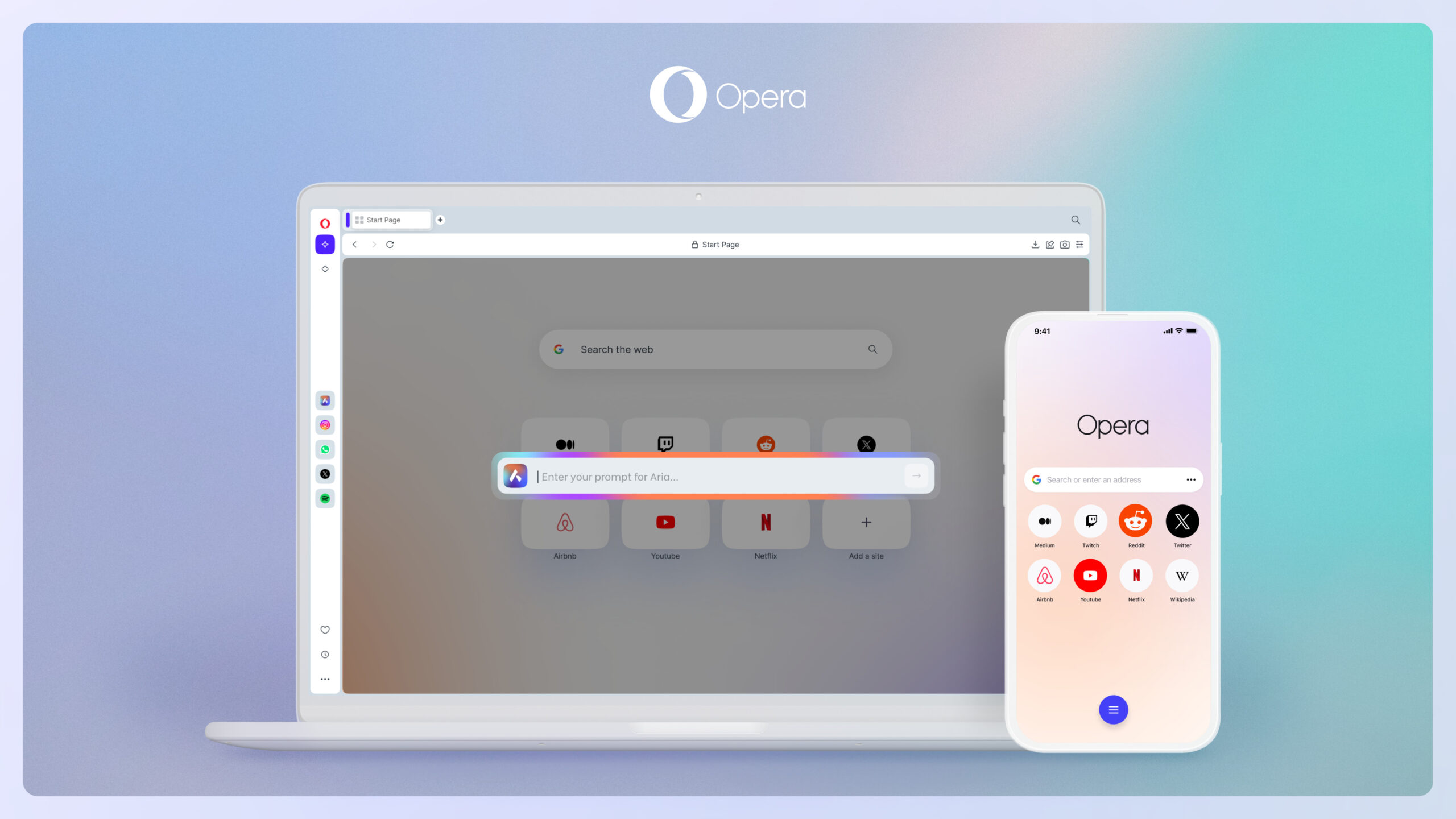

Opera se ha convertido en el primer fabricante de navegadores web en ofrecer soporte integrado para una amplia gama de modelos de IA que se ejecutan de forma nativa.

El navegador One de Opera ahora tiene «soporte beta» para 150 grandes modelos de idioma local (LLM) de 50 familias de modelos diferentes.

Estos incluyen importantes LLM locales o de código abierto como Meta's Llama, Google's Gemma, Mistral AI's Mixtral, Vicuña y muchos otros.

Al hacerlo, Opera superó a los navegadores centrados en IA como Microsoft Edge. Este último ofrece dos integraciones de IA en forma de Bing y Copilot, ninguna de las cuales funciona de forma nativa.

¿Qué significa esto para Arya?

Esta noticia significa que los usuarios de Opera One podrán reemplazar el servicio Aria AI integrado de Opera con un servicio LLM de terceros más popular. Podrán ejecutar estos programas LLM localmente en sus computadoras, lo que significa que sus datos no se transferirán a un servidor remoto. También se puede acceder desde un único navegador.

Los programas LLM locales no solo son excelentes para los entusiastas de la IA preocupados por la privacidad, sino también para aquellos que desean acceder a modelos de IA sin conexión. Esto puede resultar útil si desea utilizar LLM mientras viaja.

«La introducción de LLM locales de esta manera permite a Opera comenzar a explorar formas de desarrollar experiencia y conocimiento en el campo rápidamente emergente de la IA local», dijo Christian Colondra, vicepresidente ejecutivo de navegadores y juegos de Opera.

Acceda a LLM locales en Opera

Si bien esta es una actualización interesante para cualquier fanático de la IA, actualmente es una característica experimental y aún no está ampliamente disponible. Inicialmente, solo será accesible a través del flujo de desarrolladores AI Features Drops de Opera.

Lanzado el mes pasado, el programa permite a los primeros usuarios probar por primera vez las últimas funciones de inteligencia artificial de Opera. Afortunadamente, no es sólo para desarrolladores y cualquiera puede acceder a él.

Probar esta función requerirá la última versión de Opera Developer y de 2 a 10 GB de espacio de almacenamiento en la computadora para un material LLM local, que debe descargarse en el dispositivo.

Los LLM locales incluyen:

- llama de metta

- Vicuña

- Gema de Google

- Mixtral de Mistral AI

- Y muchas más familias

Usar LLM locales dentro de Opera One es muy simple. Después de cargar el navegador, vaya al panel lateral y elija Aria.

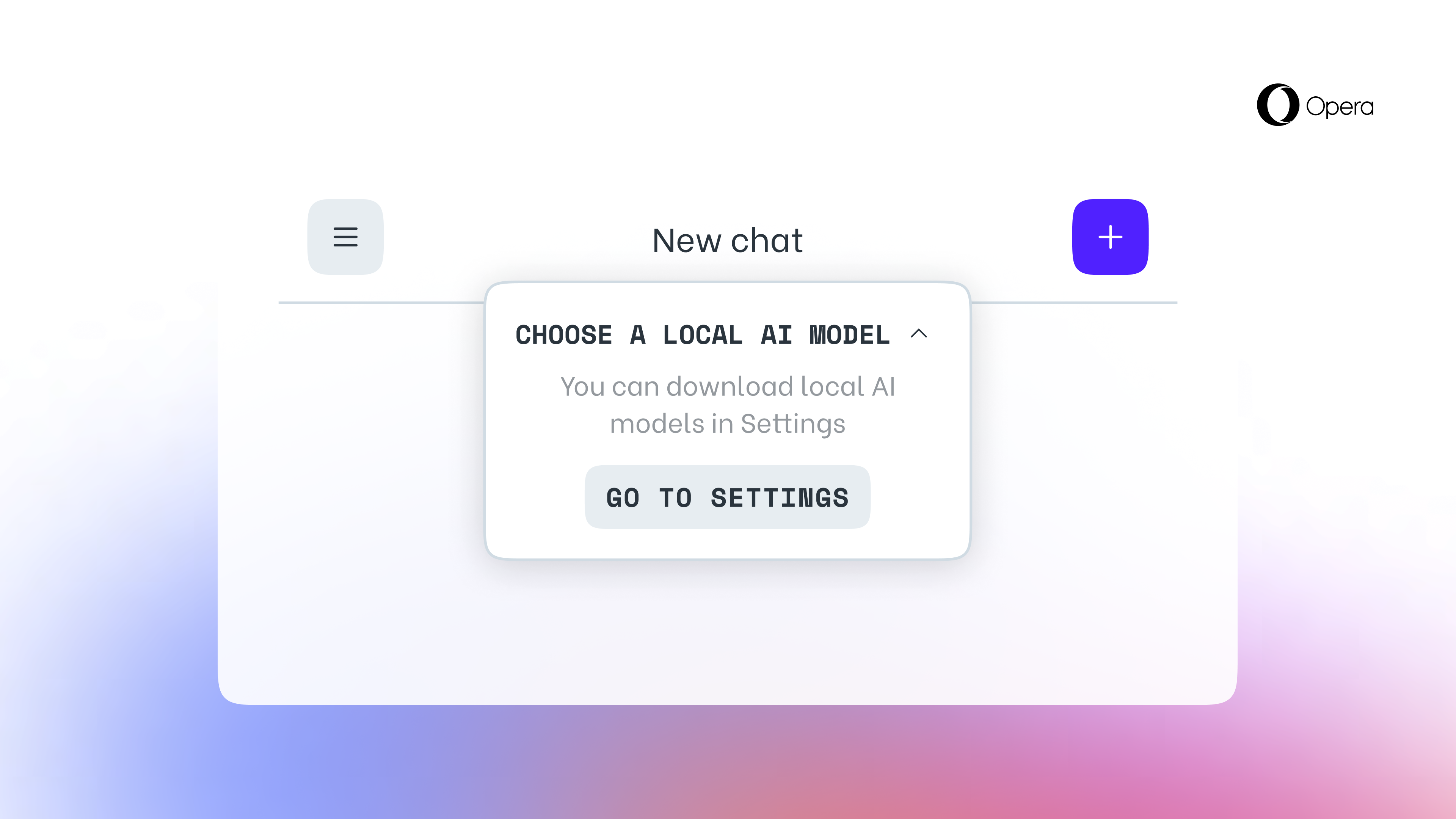

Verá un menú desplegable en la parte superior de la ventana de chat: haga clic en él y luego haga clic en la opción que dice «Elegir modelo de IA local».

Luego aparecerá un pequeño cuadro en la pantalla con un botón llamado «Ir a Configuración». Aquí puede elegir uno de los 150 LLM de 50 familias.

Después de seleccionar un LLM local, el siguiente paso será descargarlo haciendo clic en el botón con una flecha hacia abajo. A continuación, haga clic en el botón de tres líneas en la parte superior de la pantalla y luego haga clic en el botón “Nuevo chat”. Luego puede cambiar entre diferentes cursos de LLM mediante el botón «Elegir modelo de IA local».

Más de la guía de Tom

«Food ninja. Freelance pop culture fanatic. Wannabe zombie maven. Twitter aficionado.»

More Stories

La red social Butterflies AI añade una función que te convierte en un personaje de inteligencia artificial

Edición del vigésimo aniversario de Hautlence HLXX: redefiniendo el tiempo con minutos que retroceden y horas saltantes

Un marco para resolver ecuaciones diferenciales parciales equivalentes puede guiar el procesamiento y la ingeniería de gráficos por computadora